À la base des théories économiques qui gouvernent nos politiques même si elles révèlent chaque jour leur inefficacité, il y a une série de chiffres, d’indicateurs et d’hypothèses qui écartent délibérément le réel.

Dans une interview donnée au journal Les Échos en septembre 2019, Alain Minc constate que les théories économiques sur lesquelles tout le monde s’appuie aujourd’hui ne fonctionnent plus et appelle de ses vœux quelqu’un qui soit capable d’élaborer une nouvelle « théorie générale ». Les quelques exemples qu’il donne pour expliquer que les concepts utilisés aujourd’hui ne sont plus adaptés à la réalité montrent qu’il a du mal à sortir de la pensée unique car les concepts qu’il utilise ne correspondent à aucune réalité.

Il fait partie de ceux qui ont défendu « en même temps » deux théories inconciliables : celle de Keynes pour la politique économique interne – en assujettissant la vie économique à l’État-providence – et celle de Friedman pour la politique financière internationale – qui conduit à l’effacement des États face aux mouvements financiers des agents individuels. Cet assemblage intellectuellement incohérent n’a eu qu’un seul effet : favoriser les spéculateurs apatrides au détriment des agents économiques productifs et aussi des nations. De plus, pour mettre en pratique les politiques issues de ces théories, les « experts » s’appuient sur des indicateurs non pertinents instables dans le temps ou inadaptés qu’il convient de bien comprendre.

Des indicateurs non pertinents

Toutes les banques centrales des pays développés semblent s’être ralliées à un taux d’inflation idéal de 2 %. C’est l’objectif de la FED comme celui de la BCE. Les limites économiques imposées par le traité de Maastricht aux membres de la zone euro (déficit annuel limité à 3 % et dette publique inférieure à 60 % du PIB) ont été calculées avec ce taux.

Or aucun raisonnement économique sérieux ne permet de justifier ce chiffre magique qui est censé optimiser l’emploi et la croissance. Alors d’où sort-il ? En fait, on le trouve pour la première fois dans une observation statistique publiée après la seconde guerre mondiale : la courbe de Phillips. Dans cette étude qui porte sur moins de vingt-cinq ans, on constate qu’effectivement, en Angleterre, le taux de chômage tendait à décroître et devenait le plus faible quand le taux d’inflation atteignait 2 %. Indépendamment du fait que cette observation a pris place dans un temps limité, elle a vu le jour lors de la reconstruction d’après-guerre, à une époque où les frontières existaient, où le travail féminin rémunéré n’était pas aussi généralisé qu’aujourd’hui et les sources d’énergie n’étaient pas exploitées de la même manière. Par ailleurs, force est de constater qu’il ne correspond pas à ce que l’on a pu enregistrer en France. Au cours des « Trente Glorieuses », période où le taux de chômage officiel était le plus faible, le taux d’inflation était à deux chiffres.

La seule question valable est celle de savoir si, pour diriger une économie, nous sommes capables de définir un taux d’inflation idéal qu’il serait bon d’atteindre. Le taux d’inflation idéal serait celui qui donnerait envie aux agents économiques d’investir : suffisamment fort pour laisser penser que le pouvoir d’achat des consommateurs va augmenter et suffisamment faible pour que le coût des emprunts ne présente pas une barrière psychologique insurmontable tant pour ceux qui veulent prendre le risque d’entreprendre que pour ceux qui acceptent d’investir. Il s’agit donc d’un élément subjectif, variant dans le temps et dans l’espace. Même dans un univers économique mondialisé, il n’y a pas de taux d’inflation idéal commun à tous.

Une méthode de calcul instable et inadaptée

Le calcul du taux d’inflation est quelque chose de plus complexe qu’il n’y paraît au premier abord. Certaines dépenses se renouvellent tous les jours (dépenses alimentaires) alors que d’autres n’interviennent qu’à des périodes plus ou moins éloignées (ce que l’on a coutume d’appeler les dépenses d’« investissement » des ménages – immobilier, matériel électro-ménager, etc. – mais qui ne sont en fait que des dépenses de consommation d’un niveau tel qu’elles ne peuvent être supportées par les revenus moyens obtenus pendant la période où ils sont consommés).

Le calcul, tel qu’il est pratiqué aujourd’hui, souffre de deux tares essentielles. La première est qu’on ne sait pas traiter les changements technologiques. Ainsi, lorsque l’on est passé des lampes électriques à filament incandescent aux lampes à diode ou led, on a considéré que cela n’avait pas d’incidence sur le niveau des prix puisque le service n’était pas absolument identique, la lampe nouvelle étant censée durer plus longtemps et donner un meilleur éclairage. La seconde tare est que l’on ne sait pas prendre en compte le temps. Le coût retenu pour un équipement est celui de sa valeur marchande affichée au jour du calcul du taux sans tenir compte du fait de savoir s’il a été acquis au comptant ou à crédit (sur quelle durée et à quel taux ?). De plus, si on cherche à tenir compte de l’évolution des goûts moyens des consommateurs, on ne sait pas tenir compte des besoins spécifiques des uns et des autres. Pour arriver à un taux moyen on retient chaque élément du panier dit de référence avec un taux de pondération qui est censé représenter la part de chaque produit dans le budget moyen des consommateurs. Même si cette pondération n’est pas biaisée par des considérations idéologiques (comme par exemple le poids du coût du logement dans le budget actuel des Français), elle est très fluctuante, d’une région à une autre (selon que l’on habite une zone urbaine ou rurale, le poids du coût des déplacements dans le budget total n’est pas le même ; selon que l’on habite dans la plaine littorale du sud de la France ou les reliefs du nord-est, le poids du chauffage n’est pas le même dans le budget des ménages…).

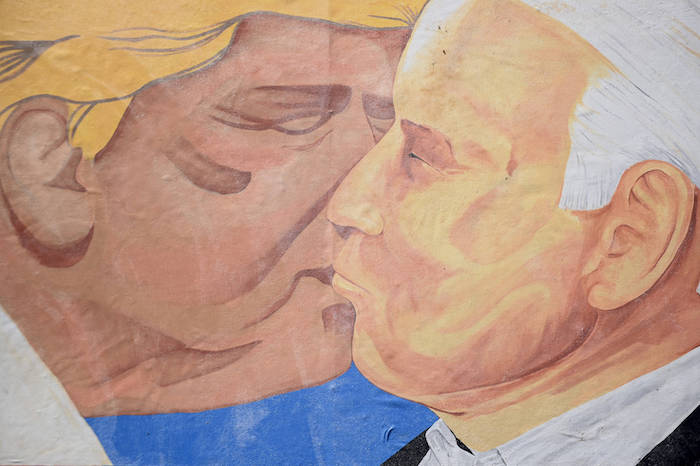

Mario Draghi et Emmanuel Macron se félicitant de leur commune approche totalement virtuelle de l’économie et des finances.

Des indicateurs hypocrites

De plus, ce taux d’inflation est toujours comparé à la croissance de la production que l’on a pris l’habitude de calculer en pourcentage d’augmentation du PIB (Produit intérieur brut). Or, le seul moyen d’évaluer cette production est de s’attacher à sa valeur marchande, autrement dit à son prix de vente sur un marché. Cette production est composée de quatre grandeurs qu’il faut agréger. La première est la plus facile à mesurer ; c’est la production vendue. Pour celle-là on dispose d’un prix de vente objectif non discutable. La seconde représente la production commercialisable, déjà réalisée mais non encore vendue, autrement dit les stocks. Pour celle-là, on admet que le prix de vente unitaire sera le même que celui des produits similaires déjà vendus (il n’y aura ni invendus ni rabais). Il est plus compliqué d’intégrer la valeur de la production non marchande qui, en France, est particulièrement importante : le coût de l’État, de l’Administration, de la Santé publique, des contrôles… Pour ces grandeurs l’on ne retient pas le prix de vente puisqu’il n’y en a pas mais le coût de production ou ce qui est censé en tenir lieu. Reste enfin ce que l’on appelle économie souterraine et qui correspond aussi bien au trafic de drogue et à la prostitution qu’au travail domestique non rémunéré et au « travail au noir ». Un autre point mérite d’être souligné : ce calcul ne tient pas compte de la valeur du patrimoine (si l’on excepte la variation des stocks). Ainsi un incendie qui, l’été, détruit des hectares de pinèdes, ravage des habitations et détruit des récoltes augmente le PIB dans la mesure où il conduit à mobiliser des forces qui, autrement ne seraient pas utilisées.

Le seul intérêt que les hommes politiques ont d’assimiler la croissance économique du pays à celle du PIB ainsi calculé est qu’ils peuvent en pousser l’augmentation ; il suffit d’augmenter le nombre des fonctionnaires ou le montant des indemnités qui leur sont versées. Ces quelques développements montrent suffisamment qu’au-delà de l’incompatibilité intellectuelle des théories sur lesquelles on s’appuie aujourd’hui, les indicateurs que l’on utilise pour mesurer leur degré de réussite ou d’échec sont hypocrites.

Des justificatifs trompeurs

Les recettes que l’on a déduites de prémisses fausses, de théories mal comprises et d’indicateurs mensongers ne peuvent pas conduire aux résultats officiellement visés par les hommes politiques lors de leurs promesses électorales. Quant aux théories annexes, élaborées pour maintenir une certaine paix sociale (comme la « théorie du ruissellement »), elles n’ont jamais eu le moindre commencement d’effectivité.

Cette théorie du ruissellement est le conte de fées pour grande personne qui est le plus apprécié des élites financières car il leur permet d’acquérir à bon compte une bonne conscience. Les « ultra-riches », pour reprendre une expression chère à ceux qui contestent le système, déversent, en dépensant, du pouvoir d’achat dans les caisses de moins riches. Ces derniers utilisent ce pouvoir d’achat pour acheter à leur tour des biens fabriqués par de plus pauvres. Et ainsi de suite : de niveau à niveau, l’argent, en ruisselant, irrigue toute l’économie et chacun en est plus riche. Ce sont désormais les grands fleuves qui font les petites rivières.

En réalité, tous les fluides circulent en sens inverse. Et les petites sommes dépensées en plus par les personnes modestes vont le plus souvent grossir les bénéfices des grandes entreprises qui peuvent augmenter les distributions de dividendes accordées aux actionnaires, « créer » de la valeur actionnariale et acquérir grâce à ce surplus de nouveaux actifs financiers qui favoriseront les regroupements d’entreprises…

C’est bien pourquoi, tant que la pensée économique n’aura pas échappé aux modernes sophistes, il est vain d’espérer la rendre utile.

par François Schwerer